Il rapido sviluppo dell’intelligenza artificiale ha sorpreso l’industria tecnologica, portando con sé sia vantaggi significativi che sfide complesse. Tra le problematiche più preoccupanti vi sono i metodi di frode e le manipolazioni basate su deepfake alimentati da AI, che continuano a rappresentare un rischio elevato.

definizione di deepfake

I deepfake sono contenuti generati da modelli di intelligenza artificiale in cui il volto o il corpo di una persona viene alterato digitalmente, sovrapponendolo a quello di un’altra. Questo porta alla creazione di situazioni in cui la vittima appare coinvolta senza esserlo realmente. Anche i file audio possono essere manipolati per “clonare” la voce di qualcuno, facendolo dire ciò che si desidera.

accessibilità degli strumenti deepfake

Negli ultimi anni, la disponibilità di strumenti per la generazione di immagini e video è aumentata notevolmente. Ad esempio, ByteDance ha introdotto OmniHuman-1, un modello capace di produrre video deepfake con risultati estremamente realistici. Questi sviluppi hanno reso tali tecnologie accessibili a un numero sempre maggiore di utenti, compresi studenti e artisti.

- ByteDance – OmniHuman-1

- Studenti

- Artisti

incidenti legati ai deepfake alimentati da AI

I casi di frodi utilizzando i deepfake sono numerosi e variegati. Tra gli esempi recenti si trovano promozioni fraudolente nel settore delle criptovalute utilizzando le sembianze del famoso investitore Vijay Kedia e video falsi con Elon Musk che pubblicizzano criptovalute. Inoltre, pratiche come la sextortion, dove vengono create immagini compromettenti per estorcere denaro, stanno diventando sempre più comuni.

- Vijay Kedia

- Elon Musk

- Casi di sextortion

aumento della ricerca sulla rilevazione dei deepfake

L’interesse verso i metodi per identificare i deepfake è in crescita. Le ricerche online relative alle “immagini deepfake” sono aumentate del 15% nel 2024, evidenziando una crescente preoccupazione tra gli utenti riguardo alla veridicità dei contenuti multimediali. La necessità di strumenti efficaci per riconoscere questi contenuti sta diventando sempre più evidente.

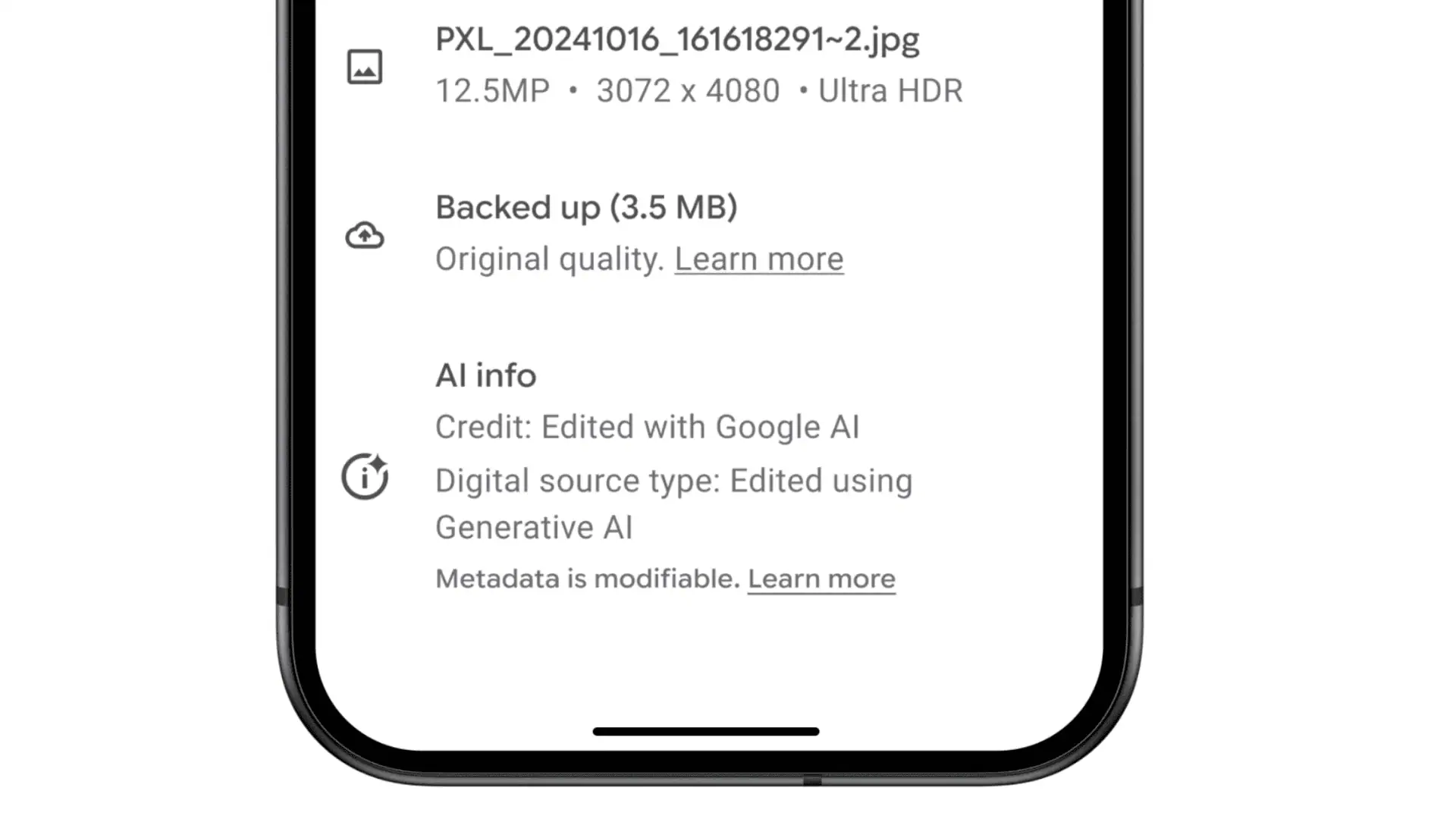

iniziative per garantire trasparenza nell’era dell’AI generativa

L’industria tecnologica non è rimasta ferma davanti a queste problematiche; è stata fondata la Coalition for Content Provenance and Authenticity (C2PA). Da questa iniziativa nasce “Content Credentials”, uno standard progettato per garantire trasparenza nei contenuti manipolati dall’intelligenza artificiale. Google ha anche presentato “SynthID”, un sistema destinato all’identificazione dei contenuti modificati tramite strumenti AI.

h4>suggerimenti per evitare truffe basate su deepfake

Mentre molti deepfake possono apparire indistinguibili dalla realtà, ci sono alcune misure preventive utili:

- Mantenere un atteggiamento scettico verso contenuti che coinvolgono personaggi pubblici.

- Verificare le fonti sui social media ufficiali delle figure coinvolte.

- Abilitare funzionalità di identificazione dei contenuti AI sui propri dispositivi.

L’adozione da parte degli sviluppatori delle tecnologie AI degli standard come “Content Credentials” potrebbe rappresentare un passo importante verso una maggiore sicurezza nella fruizione dei contenuti digitali.

Lascia un commento