Il consumo di energia è un tema centrale nell’ambito dell’intelligenza artificiale, soprattutto considerando la crescente richiesta di potenza computazionale per il funzionamento dei modelli, come ChatGPT. L’uso di queste tecnologie, sebbene accessibile, comporta un elevato fabbisogno energetico, sollevando interrogativi sull’impatto ambientale di queste operazioni.

consumo energetico di ChatGPT: quanto elettricità è necessaria?

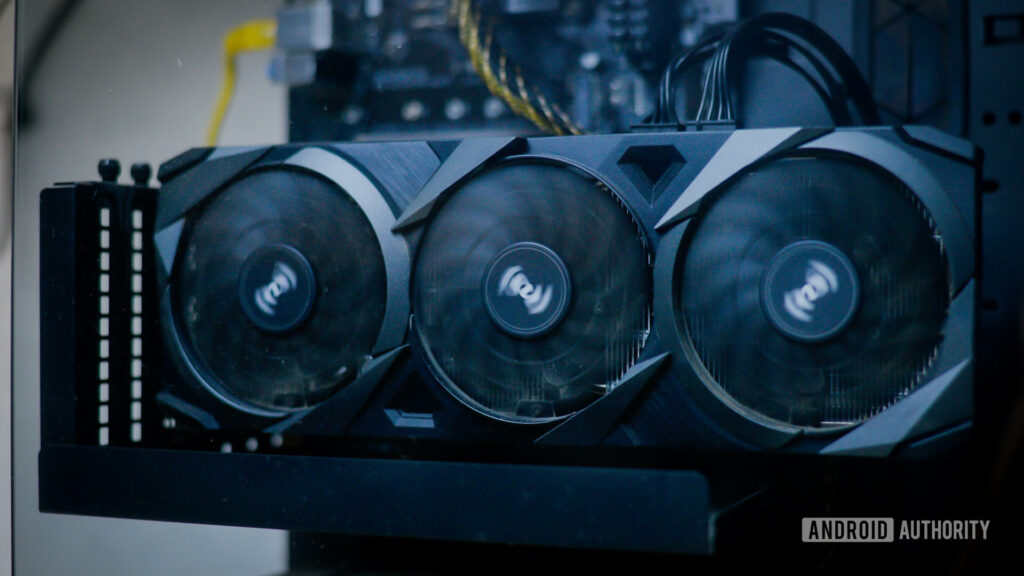

OpenAI ha riportato che il famoso modello di linguaggio GPT-3 ha richiesto circa 1.300 megawattora (MWh) per la fase di addestramento, cifra equivalente al fabbisogno annuale di circa 120 famiglie statunitensi. Un ulteriore aspetto da considerare riguarda l’energia necessaria per l’inferenza, ossia la gestione delle richieste degli utenti. Questo processo richiede server ad alte prestazioni distribuiti in data center globali, spesso alimentati con chip NVIDIA H100 che assorbono 700 watt ciascuno.

Le stime sul consumo di energia per ChatGPT oscillano, ma si concorda generalmente che il modello richiede centinaia di MWh al giorno. Questo fabbisogno potrebbe tradursi in energia sufficiente per alimentare migliaia o addirittura decine di migliaia di famiglie negli Stati Uniti per un anno intero. Con l’emergere di nuovi modelli di AI, il consumo di energia è destinato ad aumentare.

- OpenAI

- NVIDIA

- GPT-3

- ChatGPT

la questione del consumo elettrico dell’AI

Nonostante il consumo energetico dell’AI possa risultare significativo, va sottolineato che non è l’unico settore a richiedere risorse elevate. I data center che supportano l’intero ecosistema di internet hanno un consumo globale che supera i 460 TWh all’anno, in continua crescita dal 2009. In un possibile scenario pessimista, anche se i server di AI consumassero 134 TWh, tale valore rimarrebbe marginale rispetto ai numeri complessivi del settore dei data center.

Per offrire un contesto, è importante notare che nel 2019 Netflix ha utilizzato energia sufficiente a alimentare 40.000 famiglie statunitensi, evidenziando come il consumo dell’energia per la fruizione dei contenuti streaming non sollevi controversie simili a quelle dell’AI. Inoltre, i sistemi di climatizzazione assorbono circa il 10% dell’elettricità globale, un valore di gran lunga superiore alla stima peggiore per l’energia dell’AI nel 2027.

- AI

- Data Center

- Netflix

- Climatizzatori

aumento dell’efficienza: la domanda di energia dell’AI potrebbe stabilizzarsi?

Con l’evoluzione delle tecnologie AI, sono stati sviluppati modelli sempre più compatti e efficienti. A seguito del lancio di ChatGPT nel 2022, sono emersi modelli che offrono performance competitive con un consumo energetico notevolmente ridotto. Ad esempio, il recente GPT-4o mini ha dimostrato significativi risparmi sui costi del calcolo, suggerendo una diminuzione dei consumi elettrici.

Inoltre, si osserva una crescente tendenza verso la elaborazione locale di compiti come la sintesi e la traduzione, utilizzando modelli più piccoli. Anche se tali tecnologie aumentano leggermente il consumo sui dispositivi, i benefici in termini di produttività possono giustificare il modesto incremento dei costi energetici. È necessario valutare se l’AI rappresenti un’evoluzione imperativa o un inutile spreco di risorse, cosa che richiederà tempo per definirlo chiaramente.

- Generative AI

- GPT-4o mini

- Elaborazione locale

- Produttività

Lascia un commento